Chaudhuri K, Monteleoni C, Sarwate A D. Differentially private empirical risk minimization[J]. Journal of Machine Learning Research, 2011, 12(Mar): 1069-1109.

这篇是Chaudhuri大佬08年nips那篇的扩展期刊版本,介绍输出扰动和目标扰动两种方法。当损失函数和正则项满足一定的凸和可微条件时,理论上证明了可以保护隐私,并且为linear and nonlinear kernals提供了通用的bounds。接下来提出一种保护隐私的调参方法。

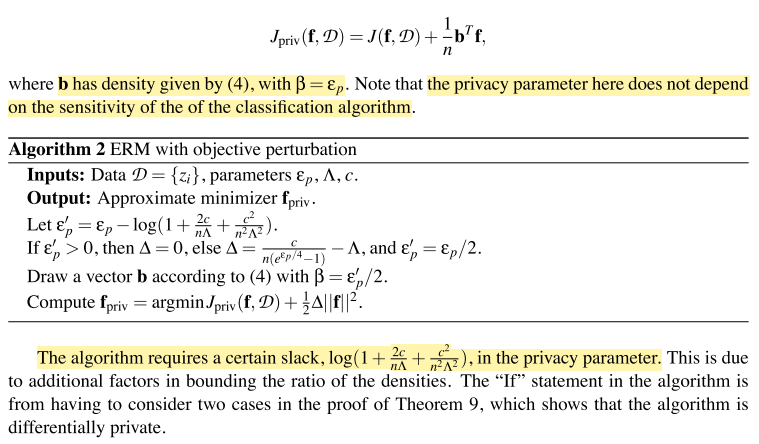

目标扰动就是直接对损失函数中的参数进行扰动。